海量小文件前提下,针对存储系统/文件系统的IOPS测试真的科学吗?

海量小文件一般简称为LOSF(lots of samll file),LOSF是存储系统的业界难题。通常认为大小在1KB~10MB的文件称为小文件,百万级数量及以上称为海量文件,由此量化定义海量小文件。

基于SAN的传统文件系统如Ext4、XFS、NTFS以及NFS、CIFS等NAS存储系统管理LOSF的性能和效率都比较低下,主要瓶颈集中在海量文件的元数据管理、存储介质的性能限制两个方面。近年来随着闪存技术和分布式文件系统的发展,存储介质性能限制逐渐消失,但海量文件的元数据管理仍然制约着文件系统和存储系统的性能。

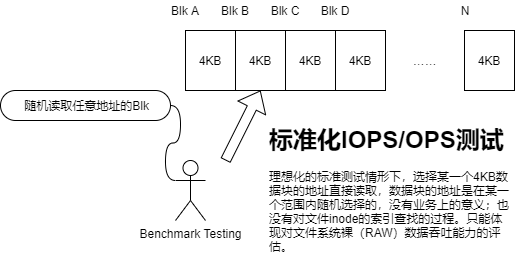

对于LOSF问题而言,业界多主张以IOPS/OPS作为性能衡量指标,这是一种误区:标准化测试情形下,IOPS/OPS只能衡量随机索引4K或者其它大小数据块访问的效率,忽略了针对在海量文件元数据中索引文件效率的衡量。

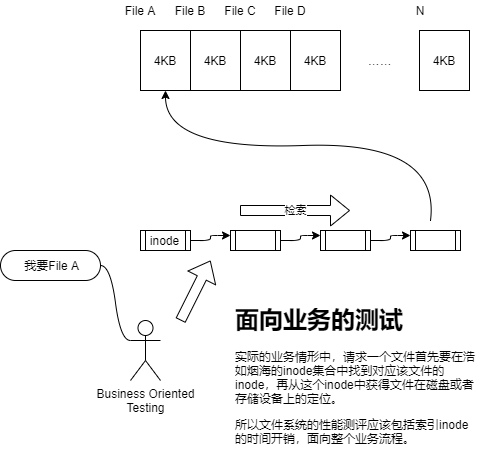

所以,衡量一个文件系统在海量文件前提下的性能应当从业务本身特点出发,在标准文件大小(如PACS影像文件典型大小为512KB左右)、预先铺底海量文件的前提下,以单位时间内能够处理的文件个数为尺度来衡量。

个人中心

个人中心 退出

退出

分类导航

分类导航